ページの先頭です

- ページ内移動用のリンクです

- ホーム

- IIJの技術

- セキュリティ・技術レポート

- Internet Infrastructure Review(IIR)

- Vol.62

- 3. フォーカス・リサーチ(2)IIJとデータセンターの変遷〜この30年を振り返って

- 目次

3. フォーカス・リサーチ(2)

IIJとデータセンターの変遷〜この30年を振り返って

3.1 1990年代「始まりはスペースの有効活用」

1985年の日本電信電話公社民営化(いわゆる通信の自由化)以前から、システムインテグレータではダウンサイジングの流れの中で計算機センターに設置されるコンピュータの小型化によって空いたスペースで他社のコンピュータを預かるビジネスがあり、国際通信会社ではこちらも交換機や伝送装置の小型化に伴って空いた通信局舎のスペースに外資系金融機関のディーラーホンや構内電話交換機を預かるビジネスがありました。いずれの建物も一般の建築物よりも頑丈に造られおり、それが今のデータセンターの原形であったと回想されます。

通信の自由化以前から、国際通信は国際電信電話株式会社(以下KDD、現在のKDDI)が専業で行っていましたが、自由化以降は複数の新規参入電気通信事業者(以下NCC)が参入し、更に自前の伝送装置を持たない第2種電気通信事業者(一般、特別)によってパソコン通信が普及し始めます。

1992年、IIJが創業し、苦労の末に特別第2種電気通信事業者として免許が交付されインターネットサービスを提供できるようになりました。最初に通信機器を設置したのは、千代田区大手町にあるKDD大手町ビル(現在はKDDI大手町ビル)でした。その後、千代田区神田神保町の岩波書店の地下にNSPIXP-1が設置されインターネットエクスチェンジ(以下、IX)での相互接続実験が始まると専用回線でルータを張り出しました。その後KDD大手町ビルにNSPIXP-2が設置されると、インターネットサービスプロバイダ(以下ISP)が集まり始めました。

ISPは専用回線や電話回線を大量に使うため、通信局舎にネットワーク機器を設置して伝送装置や交換機に構内接続することは理にかなっていますが、NTTの局舎はまだ広く解放されておらず、ISPは国内外に接続する必要があることから、KDDやNCC各社の通信局舎を使うのは当然の成り行きでした。NSPIXP-3は大阪にも開設され、1997年には日本インターネットエクスチェンジ株式会社やインターネットマルチフィード株式会社が設立されて商用IXが始まりました。日本におけるインターネットの骨格が形成された時代でした。

まだ、データセンターという言葉を使うこともなく、伝送設備の隣に一緒に置かれることからCo-Location、顧客の機器を預かることからHousingとも言われていましたが、冷房がキンキンに効いた「無機質で寒い部屋」というイメージで、1ラックあたり1〜2KVAを供給すれば十分だった時代です。

3.2 2000年代「インターネットデータセンター」

1990年代の後半からのインターネット接続サービスの爆発的な拡大に伴って、たくさんのISPがこぞって通信局舎を借りてサービスを提供し始めました。こうした時代の後半となる1998年10月にIIJはソニーとトヨタ自動車と合弁で株式会社クロスウェイブ コミュニケーションズ(以下CWC)を設立し、NCCとして全国網を整備して行きました。その翌年には全国にアクセスポイントを開設しました。

それと同時に国内主要都市(札幌、仙台、東京、名古屋、大阪、福岡)において床耐荷重が少し大きなビルを選定し、無停電電源装置と非常用発電機を設置したデータセンターを開設し、その後、埼玉県川口市、神奈川県横浜市に土地から建物まで自社所有のデータセンターを建設しました。このときのコンセプトは「人に優しいデータセンター」で、統一した動線や休息のできるカフェテリアの設置、会議スペースやキッティングルームの整備など、無機質な計算機センターや通信局舎からインターネット時代のインテリジェントな建物へと変貌を遂げたのです。

CWCは、データセンター開設と同時にLANの標準インタフェースであったEthernetで接続できる広域LANサービスを提供しました。物理的に離れていてもLANとしてつながれて、あたかも1つのビルに入っているかのように使える通信サービス(“バーチャルビルディング”と呼んでいました)で、距離によらない料金体系と合わせて一世を風靡し、今ではL2通信サービスのデファクトスタンダードになっていると言っても過言ではありません。

こうしたネットワークとデータセンターの進化によって、メールサービスやWebサービス、セキュリティ対策としてのファイアウォールやリモートアクセスに必要な機器を各社が設置するようになり、ISPだけでなくいわゆるコンテンツプロバイダなどのOTT事業者も集まり、レンタルサーバサービスや各種ホスティングサービスの登場によって、単なる機器の置き場ではなくこれらのシステムをインターネットに接続するための機能を提供する場所になっていきました。

こうして、「インターネットデータセンター」と呼ばれるようになり、床耐荷重も1トン/平米を超え、電力供給も複数の電源フィードが敷設され1ラック当たり4〜6KVAを前提として電源設備や空調設備が設計される時代になりました。インターネットが以前から雲(クラウド)に例えて語られていたこともあり、インターネットデータセンターはクラウドサービスの提供拠点や接続拠点へと変化していきます。

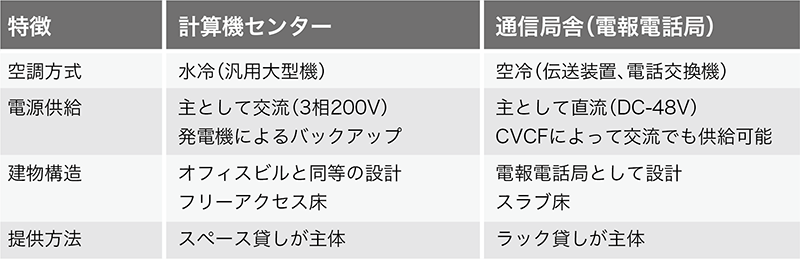

表-1 計算機センターと通信局舎の特徴的な違い

3.3 2010年代「クラウドサービスへの対応」

ネットワークを介してコンピューティングリソースを提供するクラウドサービスでは、利用者に代わってサービス提供事業者がサーバなどのIT機器を所有運用しますが、大量のIT機器を高密度で実装し効率良く運営するために、1ラック当たり10KVAを超える電力を供給し冷却できるハイパースケールデータセンターの建設が2010年代には進んでいきます。

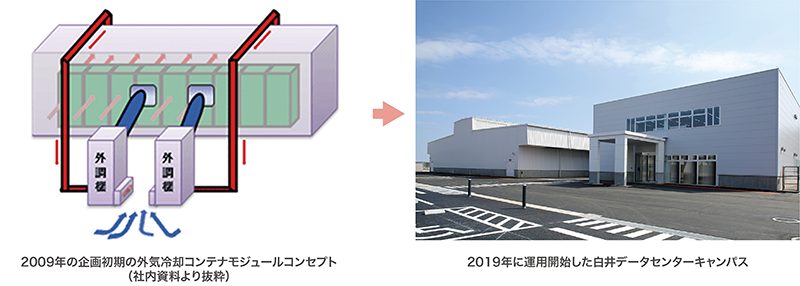

その受電容量は50MW規模になり、一般家庭(100V 50A 契約)の1万軒に相当します。単に規模が大きいだけではなく、省エネ性も備え、ハイパースケールデータセンターの普及によりエネルギー効率を示す指標であるPUE(Power Usage Effectiveness:データセンター全体の消費電力をIT機器の消費電力で除した値。1が最も良く日本の平均値が1.7)が改善されています。IIJは、クラウドサービス基盤を収容するデータセンターのために、10KVA/ラックの高密度実装を可能にし、外気冷却を用い高い省エネ性を持つコンテナモジュール「IZmo(イズモ)」を開発し、日本で初めての商用の外気冷却コンテナデータセンターの運用を2011年に開始しました。当時IIJは、他社から借りたデータセンターを再販する事業形態で、自社でデータセンターを建設したり、電気設備や空調設備を開発したりした経験はなく、その開発はゼロからのスタートでした。北米で先行しているGAFAなどのデータセンターの現地調査を行い、消費電力を低減するためには空調に外気冷却方式を導入することが最も効果があると判断し、段階的な設備増強が行えるコンテナと組み合わせる設備コンセプトを固め、パートナー企業と実証機を設計/製造し、1年間の実証を経て「松江データセンターパーク(以下松江DCP)」の構築を行うことができました。

IZmoは、最初に実装した出雲地方とクラウド(雲)にちなんで命名しましたが、その高い省エネ性能や設置が容易なことから、国内だけでなく、ロシアの水力発電所、ラオスのナショナルデータセンターなど海外に輸出し利用されています。現在は、ウズベキスタン国営通信事業者にデータセンターを提供するプロジェクトが進行中です。そして、エッジコンピューティングの普及に伴い、エッジコンピューティング環境や拠点のデジタル/IT基盤を、短期間で容易に構築、運用できるソリューション「DX edge(ディーエックス・エッジ)」として国内外に販売を行っています。

松江DCPは受電容量4MWと中規模なセンターですが、2010年代後半から本格的に外資のクラウド事業者向けに複数のハイパースケールデータセンターの建設が進んでいきます。そして、千葉ニュータウン中央駅周辺の印西地区からその集積が始まりました。「INZAI」といえば国際的にも通じるほど、データセンターの集積地として知名度が高い地域になっています。集積した理由は、地盤が強固、大手町30km圏内、海底ケーブル陸揚局からルート確保が容易、古くから電算センターが立地しておりインフラ整備が進んでいたなど複合的な理由が挙げられていますが、海外でもデータセンターは1ヵ所に集積する特徴があり、日本も例外ではないということになります。大阪の彩都地域や、京阪奈地区にも集積していて、今後も国内では大規模な複数の開発計画が進んでおり、この傾向は変わらないと考えられます。

IIJも2019年、事業規模の拡大に伴い、この印西地区(白井市は印西市に隣接)にハイパースケールデータセンターとして、「白井データセンターキャンパス(以下白井DCC)」を構築し、運用を開始しました。4万平方メートルの敷地に、最大受電容量50MWまで拡張可能で、松江DCPがコンテナ単位(9ラック)で増設するのに対し、白井DCCは、サービス基盤の増設単位が大きくなったことに対応するため、最初に1000ラック規模のシステムモジュール棟を建設し、その中を4つのモジュールに分割し、順次増設できる構造としました。また、外気冷却方式を大規模に実装し松江DCPと同様に高い省エネ性を備えています。空調は外気冷却に加えハイパースケールデータセンターでも多く取り入れられている壁吹き出し方式とし、低速で大容量のエアフローにより、従来の2重床の下から勢い良く冷気を吹き出す方式に比べ、省エネで働きやすい環境を実現しています。

2010年代は、クラウドサービスの普及に伴い、ハイパースケールデータセンターの集積が進んだことや外資系事業者の市場参入などによりデータセンター業界が大きく変容しました。IIJは、この変化に対応するため、図-1のようにゼロからコンテナモジュールを開発し、ハイパースケールデータセンターの構築まで漕ぎ着けました。そして、2023年には白井DCC2期棟の運用を開始し、現在は2026年の運用開始に向け3期棟の検討を進めており、AIや量子コンピューティングなど、これまで以上の激変が予測される2020年代に向けて、新たなデータセンターの形を模索し続けています。

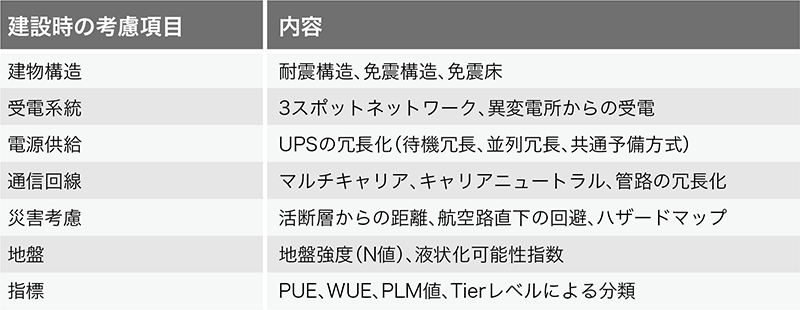

表-2 データセンター建設時の考慮事項

図-1 無から有を生み出し新しいデータセンターの形を創造

3.4 2020年代「次世代のデータセンター」

こうした変遷をたどったデータセンターには、これから何が必要とされるでしょうか。データセンター設備のライフサイクルは10年以上と、IT機器の3〜5年と比較して長く、中長期視点で社会的な潮流や技術動向を捉えることが求められます。サステナビリティの要請や、生成AI/LLM、ポスト5Gといった技術革新が進みつつある中で、次世代のデータセンターに向けてIIJが注力する3つのテーマを紹介します。

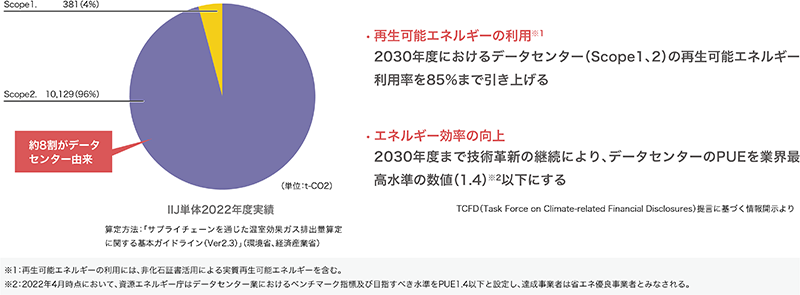

カーボンニュートラル

IT機器を集約し効率的に運用するデータセンターの利用は、社会全体の省エネに貢献する一方、施設自体のエネルギー消費が注目されています。2023年に改正省エネ法が施行され、データセンター業にベンチマーク制度(PUE1.4以下)が導入されたことに加え、新たに非化石エネルギーへの転換計画の提出も義務付けられました。また、東証プライム上場企業にTCFD提言に基づく気候変動リスクの情報開示が実質的に義務化されたこともあり、データセンターのカーボンニュートラル化は喫緊の課題となっています。IIJにおいても、温室効果ガス排出量(Scope1、2)(注1)の約8割をデータセンターが占めており、「再生可能エネルギーの利用」と「エネルギー効率の向上」への目標を設定し取り組んでいます(図-2)。

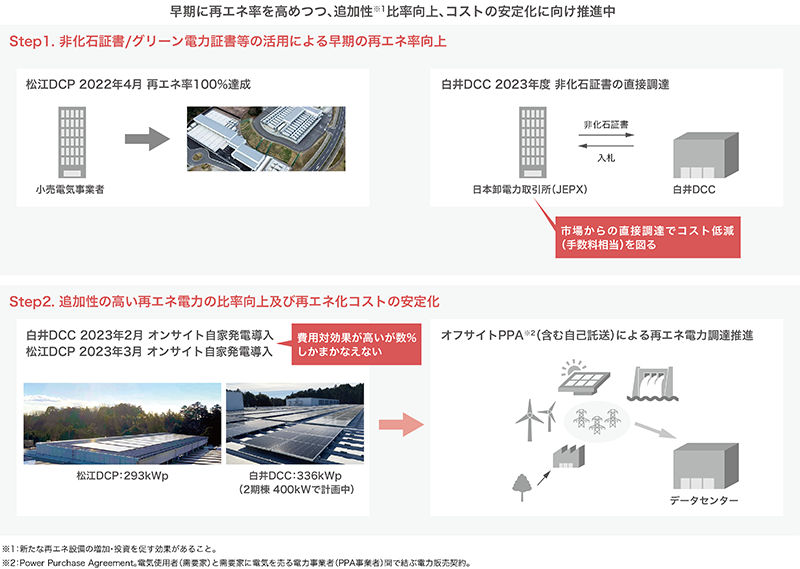

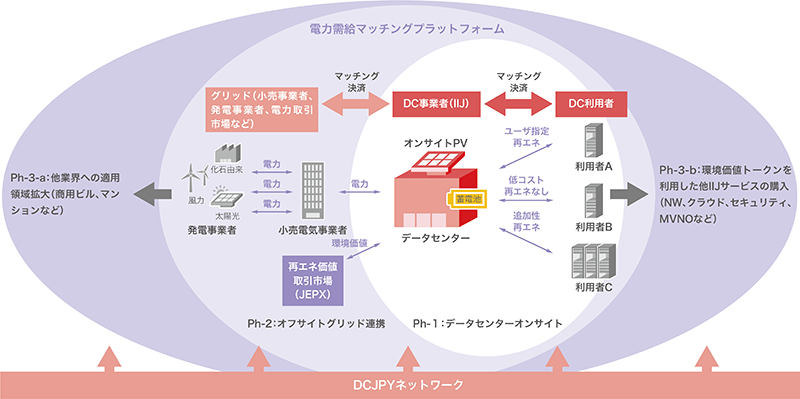

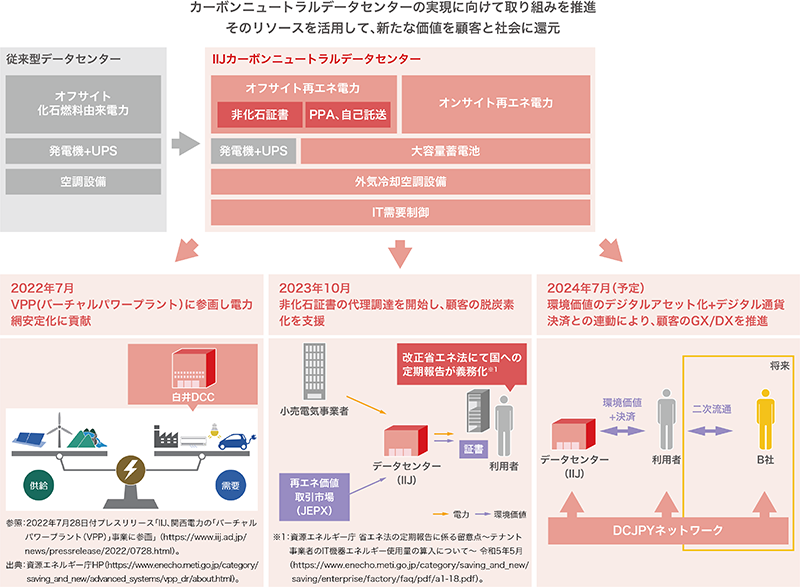

「再生可能エネルギーの利用」は電力の「量」に加え、CO2を排出しない「発電種別」を意識する新たな取り組みです。IIJデータセンターでは、納期、コスト動向などにより各調達手法を評価し、複数の手法を組み合わせることで、早期に再エネ率を高めつつ、追加性の高い電力比率の向上、調達コストの安定化を図っています(図-3)。これまでに、一般社団法人日本卸電力取引所(JEPX)の「再エネ価値取引市場」に加入し市場から直接証書を調達したり、データセンター敷地内に太陽光発電設備を導入することで再エネ調達コストの低減を実現してきましたが、従来からの省エネ性の追求と合わせオフサイト電力の調達などによりカーボンニュートラルの達成を目指しています。そしてこれらのリソースを活用し、データセンター利用者へ環境価値を提供する新サービスを開始(2023年10月)しました(図-4)。2024年7月には、環境価値をデジタルアセット化(トークン化)して提供する計画で、環境価値取引のビジネス開発につながる取り組みも進めています(図-5)。また、データセンター内の蓄電池を利用したVPP(バーチャルパワープラント・仮想発電所)事業への参画(2023年度〜)や、環境省が進める脱炭素先行地域に島根県松江市の共同提案者として参画し災害時に蓄電池による地域への電力供給を計画しており、電力網の安定化やレジリエンス強化といった社会課題の解決に貢献するデータセンターの新たな役割へも挑戦しています。

図-2 IIJのカーボンニュートラルへの取り組み

図-3「再生可能エネルギーの利用」への取り組み

図-5 脱炭素ニーズの本格的な高まりに向けて

AI制御・自動化

データセンターにおいてカーボンニュートラルを実現するためには、使用するエネルギーの低減が必要不可欠です。サーバなどIT機器以外で消費されるエネルギーとして最も大きな割合を占めるものは、IT機器を冷却するための空調機器です。データセンターのPUEを最良値の1.0に近づけるため、IT機器の冷却に外気を積極的に用いたり、高効率な機器を採用しています。また、白井DCCでは、AI技術を活用して、省エネ性能をさらに向上させる取り組みを行っています。センサーやIT機器から得られたデータをAIに学習させることで、より効果的な空調システム全体の制御を目指しています。このような空調システムの自動的に加え、データセンターの入退館時の受付業務を自動化する「自動受付システム」をはじめ、データセンターサービスを提供する上で必要となる各種業務の自動化も推進し、データセンターで業務を行うオペレータの業務負荷軽減を図っています。国内の労働人口の減少、働き方改革といった動向から、データセンターの規模が拡大する中で提供品質を維持するにあたり、オペレーション要員の追加、育成といった人手に頼った体制維持が困難な状況になっていくと予想されるからです。自動化の領域は順次拡大することを考えており、例えば前節で述べたデータセンター利用者向けに環境価値付きの電力を供給する取り組みについても、電力需給マッチングプラットフォームの構築やデジタル通貨を用いた決済などを活用することで、単純な自動化に留めず、高度化、高品質化の達成を図りたいと思っています。

図-4 カーボンニュートラルデータセンターの先にあるもの

サーバ高密度化・水冷対応

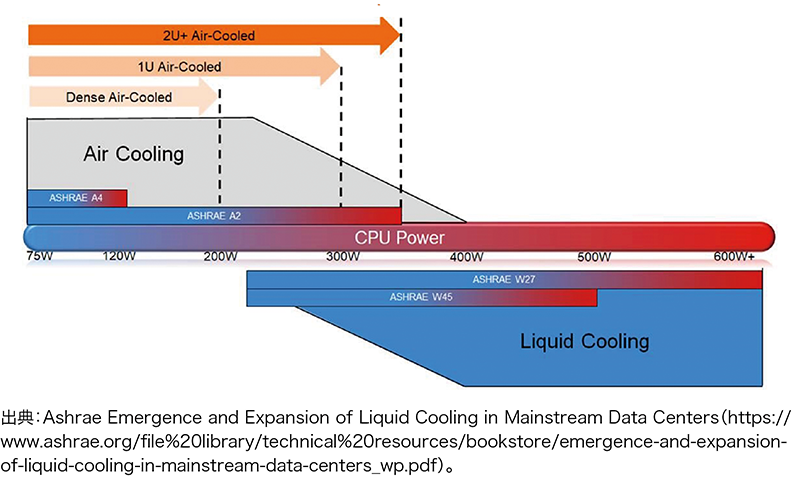

生成AI/LLMなどの技術の活用が様々な分野で進み、CPU/GPUの処理能力が増大していく中で、これらのCPU/GPUを大量に効率良く設置できることが次世代のデータセンターには求められます。今後導入されるデータセンター向けCPUは、TDP(Thermal Design Power)が300Wを超えており、AI需要への対応のため今後更に増加していくと考えられます。アメリカ暖房冷凍空調学会「ASHRAE(アシュレー)」によれば、このTDPが300Wを超えると、従来の空冷ではなく水を使った水冷の冷却方式を導入する必要があるとされています(図-6)。

空気により冷却できるNW機器などのIT機器も混在するため、今後のデータセンターには空冷/水冷のハイブリッド冷却機能を備え、かつカーボンニュートラルを実現するための高い省エネ性能を実現することが求められます。IT機器とファシリティの結びつきも強くなり、これまでに大規模データセンター・クラウドサービスの構築・運営に実績を持つIIJの強みが生かせる領域であると考えています。IIJは、経済産業省、新エネルギー・産業技術総合開発機構(NEDO)の公募「ポスト5G情報通信システム基盤強化研究開発事業/ポスト5G情報通信システムの開発(委託)」に株式会社Preferred Networks、国立大学法人北陸先端科学技術大学院大学と「超高効率AI計算基盤の研究開発」を共同提案し採択されました。IIJは高密度データセンターの基盤技術に関する研究開発を担い、高密度データセンターレファレンスモデルの開発や、空冷空調技術と水冷技術を組み合わせたハイブリッド冷却方式の確立、AI計算基盤に対応する省エネ評価指標の策定と評価方法の開発に取り組んでいきます。

図-6 TDP(CPU Power)と冷却方式

3.5 まとめ

データセンターは、ITシステムの利用者から意識をされることは多くないものの、最近ではデジタル化社会を支える重要インフラとして認知が進みつつあります。計算機センター/通信局舎、コロケーション、クラウド、ハイパースケールとこれまでたどったデータセンターの道のりを踏まえ、今後も新しいデータセンターの形を追求し、社会を支えるインフラの運営を続けていきます。

- (注1)Scope1、2(自社での温室効果ガス排出):自社での燃料の使用や工業プロセスによる直接排出及び自社が購入した電気・熱の使用に伴う間接排出(GHGプロトコル定義)。

執筆者プロフィール

山井 美和(やまい よしかず)

IIJ 常務執行役員 基盤エンジニアリング本部長

久保 力(くぼ いさお)

IIJ 基盤エンジニアリング本部 基盤サービス部長

2008年にIIJに入社。データセンター事業を統括し、松江DCP、白井DCCを構築。早期のカーボンニュートラル実現を目指す。

堤 優介(つつみ ゆうすけ)

IIJ 基盤エンジニアリング本部 基盤サービス部 データセンター基盤技術課長

2015年IIJに入社し国内外でのデータセンター構築に従事。電力分野での新技術検証等、次世代データセンターの技術開発を推進中。

三村 恭弘(みむら たかひろ)

IIJ 基盤エンジニアリング本部 基盤サービス部 データセンター基盤技術課

- 3. フォーカス・リサーチ(2)

IIJとデータセンターの変遷〜この30年を振り返って

ページの終わりです